por qué las GPU son la clave de toda la revolución tecnológica

Lo que comenzó como un componente informático utilizado para jugar videojuegos, utilizar programas de edición de imágenes, vídeo o modelado 3D se ha convertido en En el corazón de toda la tecnología moderna. Las tarjetas gráficas (GPU) ya no solo procesan gráficos, ahora pueden entrenar inteligencia artificial, administrar redes 5G y 6G y optimizar centros de datos. Comprender cómo funcionan las GPU es comprender cómo funcionará el mundo conectado del futuro.

De accesorios gamer a motores del futuro digital

Mucha gente todavía piensa que las tarjetas gráficas sirven para jugar o reproducir vídeos, pero ahora pueden El componente informático más importante del siglo XXI.. Las GPU (Unidades de Procesamiento Gráfico) han dado un salto adelante y ya no se utilizan sólo para la generación de imágenes o vídeos acelerados por hardware, ahora se utilizan en nuevos modelos de inteligencia artificial o redes móviles de nueva generación.

Por qué las tarjetas gráficas cambiaron la historia de la informática

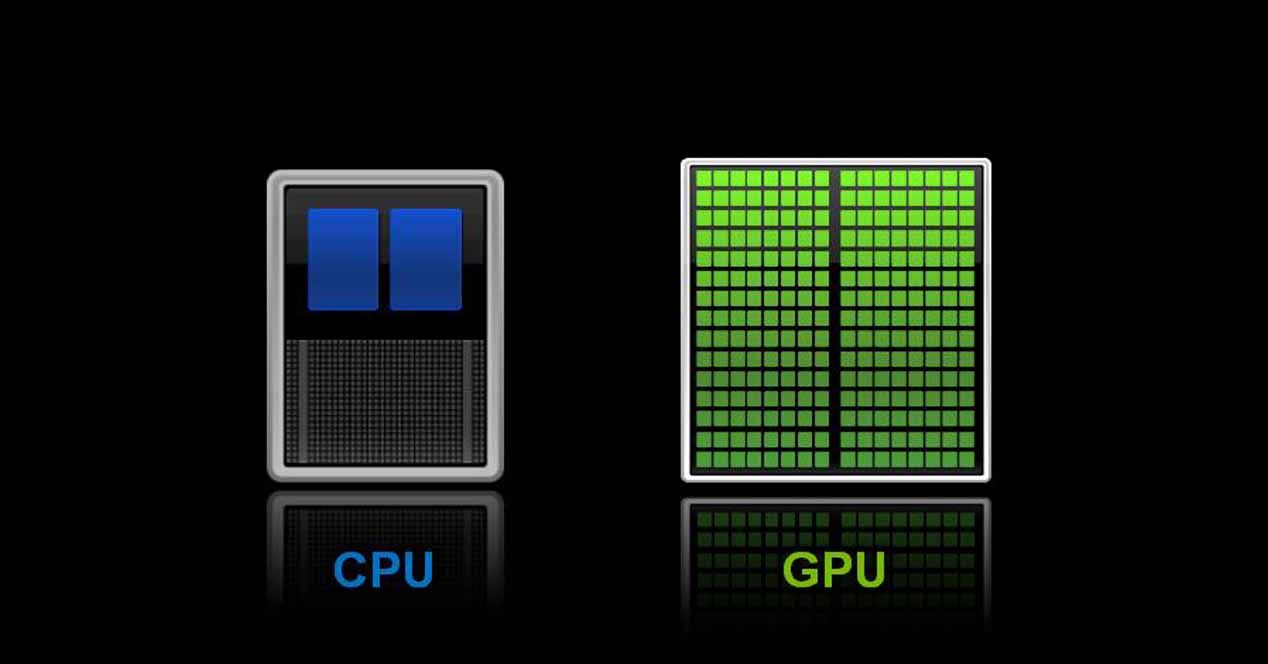

El procesador, o CPU, ha estado en el corazón de las computadoras durante décadas. Hubo un tiempo en que los procesos se volvieron tan complejos y crecieron tan rápido Una sola CPU no es suficiente. Utilizadas originalmente para gráficos 3D, la gran ventaja de las GPU es que pueden realizar millones de operaciones matemáticas simultáneamente.

| característica | CPU (Unidad Central de Procesamiento) | GPU (Unidad de procesamiento de gráficos) |

|---|---|---|

| diseño del núcleo | Pocos núcleos, pero muy potente y rápido. | Miles de núcleos más pequeños y eficientes. |

| Tipo ideal de tarea | Tareas secuenciales y complejas (por ejemplo: arrancar el sistema operativo). | Realice muchas tareas repetitivas en paralelo (por ejemplo, renderizar un fotograma). |

| memoria | Al utilizar la RAM principal del sistema, la latencia es mayor. | Dispone de su propia memoria ultrarrápida (VRAM) a la que se puede acceder de forma inmediata. |

| Funciones principales | El «cerebro» de la computadora coordina todas las operaciones. | El «músculo» para el trabajo informático pesado. |

Esta capacidad matemática para realizar operaciones paralelas crea la GPU. La herramienta perfecta para entrenar algoritmos de inteligencia artificial. También se utilizan para simular sistemas físicos o procesar grandes cantidades de información científica.

«La GPU se está convirtiendo en una plataforma informática universal en la era de la IA» El director ejecutivo de Nvidia, Jen-Hsun Huang, insinuó en la conferencia GTC 2024.

GPU e IA: la combinación perfecta

La inteligencia artificial actual se basa en redes neuronales Aprenden multiplicando matrices de números enormes. Esta es una explicación básica, pero nos ayuda a entender la importancia de las tarjetas gráficas en toda la revolución.

| Ámbito de aplicación | Misión crítica de la GPU | Principales beneficios/impactos |

|---|---|---|

| Inteligencia artificial y aprendizaje automático | Realice multiplicaciones de matrices gigantes para entrenar redes neuronales profundas y realizar inferencias en tiempo real | Acelera significativamente el entrenamiento de modelos complejos como ChatGPT, Gemini y Claude, y permite predicciones instantáneas en aplicaciones comerciales. |

| Telecomunicaciones (5G y 6G) | Procese señales complejas y gestione el tráfico de datos en tiempo real en antenas y centros de datos | Reduzca la latencia crítica y prepare una conectividad ultrabaja para aplicaciones como vehículos autónomos y realidad holográfica en el espacio 6G. |

| Procesamiento y visualización de gráficos. | Ejecute computación paralela masiva para renderizado 3D en tiempo real para medios y videojuegos. | Ofrece experiencias visuales con calidad cinematográfica, transmisión de video de alta resolución y experiencias inmersivas de realidad virtual y aumentada. |

| Simulación Científica y Computación Científica | Ejecute modelos de simulación complejos para procesar grandes cantidades de datos para investigación y exploración. | Acelerar la investigación en modelización climática, física de partículas, bioinformática y diseño de fármacos, reduciendo significativamente el tiempo de desarrollo. |

La GPU tiene un rendimiento incomparable en este trabajo, completando el trabajo de la CPU en segundos. Tarda horas o días en completarse. Sin una tarjeta gráfica es imposible entrenar modelos como ChatGPT, Gemini o Claude.

Este salto llevó la inteligencia artificial de algo limitado a unos pocos a algo que cualquiera podría usar en su teléfono o navegador. Y no hablamos sólo de la versión en la nube, sino también de la IA nativa en terminales móviles, como Apple Intelligence en el iPhone.

Las GPU también se están apoderando de las telecomunicaciones

La tarjeta gráfica también es Protagonista en el mundo de las telecomunicaciones.. Las antenas 5G o los centros de datos utilizan estas GPU para procesar señales, reducir la latencia y distribuir la carga del tráfico.

De hecho, con la esperada llegada del 6G en 2030, se espera que Cada nodo combina IA y GPU Gestiona conexiones para vehículos autónomos, cirugía remota o realidad holográfica en tiempo real y sin latencia.

El acuerdo firmado por Nvidia y Nokia el 28 de octubre es un testimonio de la revolución que se avecina. Aquí lo confirman «La tecnología AI-RAN será promovida y probada como parte del proceso de innovación y desarrollo 6G». ellos esperan Las pruebas comenzarán en 2026.centrándose en la verificación in situ de las mejoras de rendimiento y eficiencia para los clientes.

«El próximo gran salto en telecomunicaciones no se limita a la transición de 5G a 6G; es un rediseño fundamental de las redes para ofrecer conectividad impulsada por IA capaz de procesar información desde el centro de datos hasta el borde de la red. Nuestra alianza con NVIDIA y su inversión en Nokia acelerarán la innovación AI-RAN y facilitarán que todos puedan poseer un centro de datos de IA».dijo Justin HotardPresidente y director ejecutivo de Nokia.

Eficiencia: un nuevo desafío para las GPU

Sin duda, el mayor problema de todo esto tiene que ver con el consumo energético. siempre ChatGPT se considera un «desperdicio de agua» Esto fue así cada vez que le hicimos algunas preguntas, pero con matices. Decimos esto porque el agua se utiliza para enfriar los centros de datos que ejecutan importantes modelos de inteligencia artificial.

De hecho, los últimos modelos que ya están en el mercado, p. Nvidia H200 o AMD MI300Xla eficiencia por vatio aumenta en un 30%. La Agencia Internacional de Energía confirma que los centros de datos representan más del 2,5% del consumo eléctrico mundial.

Por tanto, mejorar la eficiencia de las GPU será clave para sostener la revolución digital en el tiempo. Para que nos hagamos una idea, entrenar un modelo como GPT-4 consume aproximadamente 6.500 MWh. Esto equivale al consumo anual de electricidad de 600 hogares.

en conclusión

Las tarjetas gráficas ya no son un componente informático para los jugadores, sino el futuro de todo el ecosistema digital que nos rodea en los próximos años. De crear y mover mundos virtuales, ahora serán ellos quienes conecten el mundo real, permitiendo la inteligencia artificial, las redes globales y la informática de próxima generación.

Si el siglo XX es el siglo del procesador, XXI pertenece a la tarjeta gráfica.

Fuentes de referencia:

Preguntas sobre la GPU Mientras la CPU realiza tareas secuenciales; la GPU los realiza en paralelo, lo que lo hace más rápido.

Porque las redes neuronales se basan en operaciones matriciales realizadas por la GPU a máxima velocidad.

Se espera que el mercado cambie con la llegada de IA-RAN, que son dispositivos de red muy potentes capaces de gestionar el tráfico mediante inteligencia artificial.

No, siempre son complementarios. La CPU coordina y la GPU realiza el trabajo por lotes.

¿Cuál es la diferencia entre CPU y GPU?

¿Por qué son tan importantes para la inteligencia artificial?

¿Qué papel juegan en el 5G y el 6G?

¿Reemplazarán las CPU?

Puedes consultar la fuente de este artículo aquí