por qué ya no verás resúmenes de salud

este cibercondria Este concepto hace referencia a la búsqueda obsesiva de patología en internet cuando descubrimos algún síntoma en nuestro cuerpo. El autodiagnóstico a través de los resultados de los motores de búsqueda puede generar ansiedad y preocupación indebidas, y la mayoría de las veces es poco realista o exagerado. junto con AIeste problema ha aumentado, y Google quiere solucionar este problema y eliminar los fragmentos de Gemini en estos casos.

Cuando lo hacemos, AI suele recomendar acudir a un profesional de la salud. consulta medica Según nuestros síntomas. Sin embargo, muchos usuarios nos dejan con posibles motivos por los que podemos estar sufriendo una determinada enfermedad o condición, o incluso buscan consejos de alivio en lugar de pedir cita con el médico o acudir a urgencias. A pesar de los enormes avances en materia de inteligencia artificial de los últimos años, la ilusión continúa y puede que esté equivocada.

uno Alucinaciones en IA Término utilizado cuando un modelo genera información falsa o incorrecta y la presenta como información verdadera. En lugar de admitir que no sabe la respuesta, la IA tenderá a inventar una respuesta que, si bien puede resultar convincente, será mentira. Google reconoce que Gemini puede responder con datos erróneos, pero aun así proporciona un resumen de su modelo con cada búsqueda médica realizada en su motor de búsqueda. Tras una controvertida investigación publicada por The Guardian el 2 de enero de 2026, la empresa decidió eliminar la inteligencia artificial de dichas búsquedas.

Google Gemini hace consejos médicos peligrosos

Según The Guardian, los resultados resumidos de Gemini de Google son «realmente peligrosos». Por ejemplo, aconseja a las personas diagnosticadas con cáncer de páncreas que eviten alimentos grasos. Los medios contrastaron esta información con expertos que decían que la IA estaba diciendo exactamente lo contrario de lo que deberían estar haciendo. Dejar de comer este tipo de alimentos puede aumentar el riesgo de morir a causa de la enfermedad.

Además, la IA recomienda una serie de pruebas para personas con enfermedad hepática grave. Si pasan las instrucciones de la IA, pueden creer erróneamente que uno está sano y ningún tratamiento adicional.

La respuesta inicial de Google

A la luz de los hallazgos de The Guardian, un portavoz de Google defendió a la compañía, diciendo que los ejemplos compartidos eran «capturas de pantalla incompletas» y que tras la evaluación descubrieron que provenían de enlaces de «fuentes conocidas y confiables» y que siempre «recomiendan buscar asesoramiento de expertos».

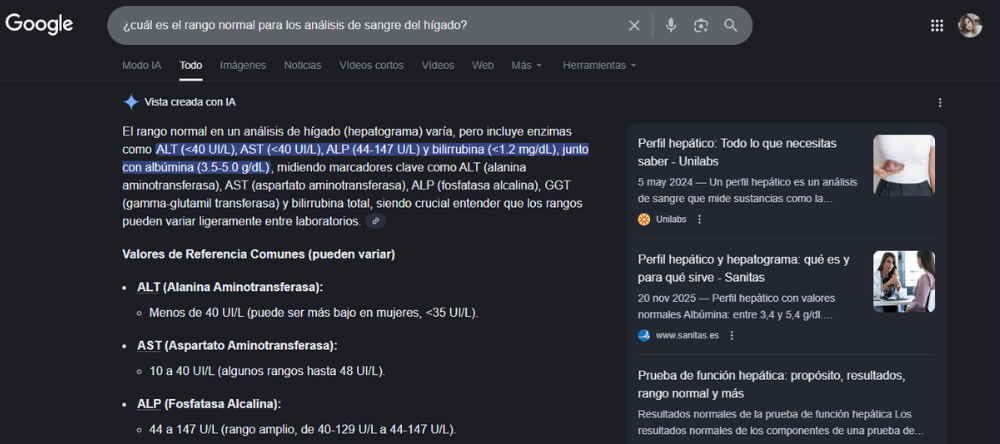

Sin embargo, parecen haberlo reconsiderado y están empezando a ser más cautelosos a la hora de generar fragmentos en los resultados de búsqueda médica. The Guardian descubrió que algunos perfiles de inteligencia artificial relacionados habían sido desactivados la mañana del 11 de enero de 2026. Según preguntaron en Google «¿Cuál es el rango normal para un análisis de sangre del hígado?»el resumen de Géminis ya no aparece.

La declaración de Google es más vaga: «No comentamos sobre eliminaciones individuales de la búsqueda. Si la descripción general de la IA no proporciona contexto, Nos comprometemos a implementar mejoras generales. Y, cuando corresponda, también tomaremos medidas coherentes con nuestras políticas. «Sin embargo, todo parece indicar que se toman en serio la investigación de los medios para no poner en riesgo a los usuarios ciberhipocondríacos.

Aquí en ADSLZone, buscamos el mismo problema y se dijo que Google eliminó el fragmento generado por IA, pero aún se mostraba. Completamos la verificación hoy (12 de enero de 2026) a las 2:00 p.m. Los datos todavía no proporcionan antecedentes claros y no mencionan la nacionalidad, el sexo, la edad, etc. del paciente. Son muy generales, como fue el caso de la investigación de The Guardian. Que siga apareciendo en España parece indicar que la eliminación de Gemini Answers en Google sólo se está produciendo en Estados Unidos.

Puedes consultar la fuente de este artículo aquí