así ha pasado de los armarios de una tonelada a superar los 30 terabytes

El ser humano está diseñado para dejar huella, para dejar un recuerdo del paso por este mundo y atesorar el conocimiento que va gestando a su paso. Cicerón decía que «la memoria es el tesoro y guardián de todas las cosas». La memoria en la era digital trasciende a nuestro cerebro, más ligada a un sinfín de soportes de almacenamiento que han ido evolucionando en paralelo a la propia revolución tecnológica.

Tim Berners-Lee, creador de la World Wide Web, ya defendía que los datos «son una cosa preciosa y durarán más que los sistemas en sí mismos». Incluso antaño ya tallábamos piedras, luego escribíamos en papiros, imprimimos textos con la imprenta. Y con la digitalización llegó el almacenamiento de cantidades ingentes de datos que crecen a un ritmo que desafía cualquier escala conocida.

En este viaje de construcción de una memoria artificial, el disco duro (HDD) ha sido uno de los grandes héroes silenciosos. Durante más de medio siglo, estos dispositivos mecánicos han guardado nuestros correos, nuestras fotos, nuestras ideas, nuestros fracasos y nuestros logros. Han estado en el corazón de los ordenadores, en las cámaras de vigilancia, en los servidores que hacen posible la nube. Han evolucionado desde armarios del tamaño de una nevera que apenas contenían cinco megabytes, hasta unidades delgadas capaces de almacenar casi 30 terabytes y funcionar a pleno rendimiento en los centros de datos más sofisticados del planeta.

Y, sin embargo, ahora que la inteligencia artificial reclama cada día más almacenamiento, que el vídeo en 8K se convierte en norma y que la humanidad genera más datos por hora que en siglos enteros de historia, muchos se preguntan: ¿tiene futuro el disco duro tradicional, limitado por su velocidad? ¿O está condenado a extinguirse como tantas otras tecnologías que un día lideraron y luego fueron superadas por alternativas de nueva generación, como las unidades SSD en este caso?

El primer disco duro, en 1956

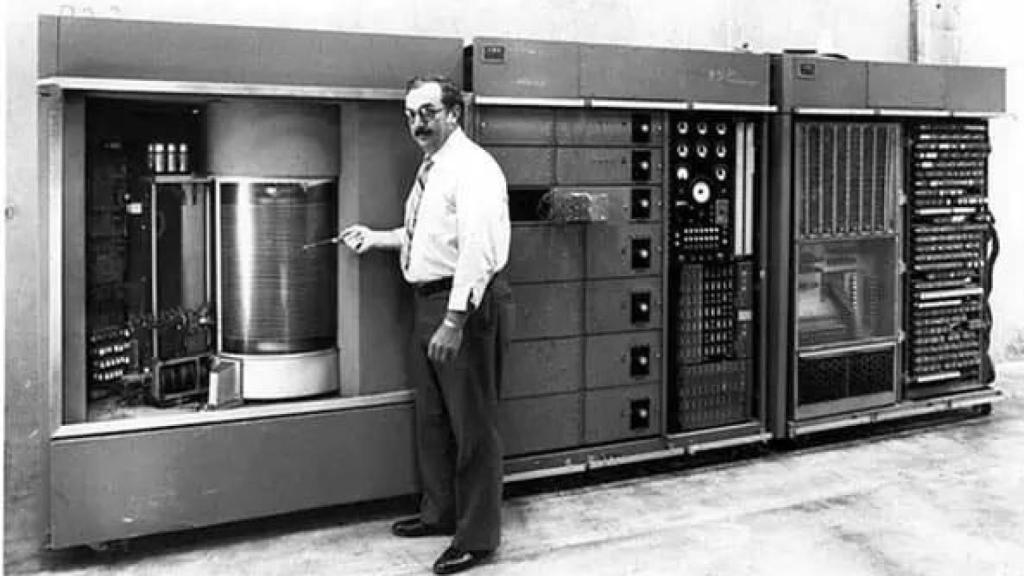

La historia del disco duro (HDD, Hard Disk Drive por sus siglas en inglés), arranca en 1956, cuando IBM presentó el primer modelo funcional: el IBM 305 RAMAC. Fue una auténtica revolución tecnológica en su época; un sistema de almacenamiento que permitía acceder directamente a los datos -una ventaja colosal frente a las lentas tarjetas perforadas o cintas magnéticas- y, por ende, inauguró el concepto moderno de “disco” y del almacenamiento magnético rotativo.

El RAMAC (siglas de Random Access Method of Accounting and Control) pesaba más de una tonelada y ocupaba el tamaño de dos neveras industriales. En su interior albergaba 50 discos de 24 pulgadas cada uno, apilados verticalmente, que ofrecían una capacidad total de apenas 5 megabytes. Hoy esa cifra resulta irrisoria: cualquier fotografía en alta resolución puede ocupar más que eso. Pero en 1956, esos 5 MB eran una proeza de la ingeniería. Su coste, no tanto: alquilar el sistema RAMAC podía costar unos 3.200 dólares mensuales (equivalentes a más de 35.000 teniendo en cuenta la inflación). .

Una imagen del IBM 305 RAMAC, primer disco duro de la historia.

Desde entonces, el HDD no ha dejado de evolucionar. Ha sido la espina dorsal del almacenamiento digital durante más de medio siglo, viviendo múltiples reinvenciones técnicas y reducciones de tamaño espectaculares. Sin embargo, en la actualidad, y con el auge imparable de las unidades SSD (Solid State Drive), muchos se preguntan si su tiempo ha llegado a su fin.

En los años 60, los primeros discos duros comerciales seguían siendo equipos grandes y costosos, muy dirigidos a grandes compañías bancarias o administraciones públicas. El IBM 2311, por ejemplo, introducido en 1964, ofrecía 7,25 MB de capacidad, ya con discos intercambiables, por unos 35.000 dólares (más de 330.000 actuales).

La década de los 70 marcó la transición hacia discos más pequeños y accesibles. Surgieron los primeros formatos de 14 y 8 pulgadas, y empresas como Shugart Associates (fundada por un exingeniero de IBM) comenzaron a explorar formatos más compactos. En 1980, Seagate lanzó el primer disco duro de 5,25 pulgadas: el ST-506, con 5 MB de capacidad y un precio inicial de 1.500 dólares. Este modelo, ideado para integrarse en ordenadores personales, sentó las bases del HDD tal y como lo conocemos hoy.

La carrera por la capacidad se aceleró en los años 90. Con el auge del PC doméstico y el incipiente mercado multimedia, el disco duro pasó de los 100 MB a los 1 GB en apenas cinco años. En paralelo, el precio por megabyte se desplomó: de los 10 por MB en 1985 a 0,10 por MB en 1995.

Ya nos movemos en la actual era de los discos de 3,5 y 2,5 pulgadas, con tecnologías como la grabación perpendicular (PMR), introducida en 2005, que permiten multiplicar la densidad de datos en los platos magnéticos. A ello se sumó la entrada del helio como gas de relleno para reducir fricción y aumentar el número de discos internos.

Con todo ello, a finales de la década de 2010, la industria presentó discos de 10 TB, 12 TB y hasta 16 TB, orientados a centros de datos, copias de seguridad y almacenamiento de alta capacidad. En paralelo, el coste por gigabyte cayó a niveles impensables: de los 0,50 dólares en 2005 a apenas 0,015 en 2020.

Disco duro mecánico

Hoy, el HDD más avanzado del mercado ofrece cerca de 30 terabytes de capacidad en un solo dispositivo. Y aunque el precio de estos dispositivos de vanguardia sigue siendo notorio, su coste por gigabyte sigue siendo insuperable por parte de las unidades SSD: menos de 0,02 euros por GB, frente a los 0,05 o 0,10 euros que aún se pagan por memorias de estado sólido equivalentes. Es aceptado, como estándar de la industria, una relación de 1 a 7 en el coste del HDD frente al SSD.

El milagro de la ingeniería mecánica

A diferencia de las unidades de estado sólido, sin partes móviles, los discos duros tradicionales funcionan como una sofisticada combinación de desarrollo mecánico de precisión y magnetismo. Aunque su estructura básica no ha cambiado desde los tiempos del RAMAC, su ingeniería interna se ha perfeccionado hasta límites insospechados.

En esencia, un disco duro se compone de platos (discos circulares) hechos de vidrio o aluminio recubiertos de material ferromagnético, donde se almacenan los datos. Estos platos giran a gran velocidad -habitualmente entre 5.400 y 7.200 revoluciones por minuto (rpm) en modelos domésticos, o hasta 15.000 rpm en modelos empresariales- y están apilados en un eje central, separados por una pequeña distancia.

A los platos hemos de unir los cabezales de lectura/escritura, que flotan sobre la superficie a micras de distancia gracias a un sistema de actuadores de altísima precisión. A través de campos magnéticos, estos cabezales graban ceros y unos en la superficie, o los leen cuando se requiere acceso a los datos. Todo esto ocurre dentro de una carcasa hermética con un filtro de aire y, en muchos casos actuales, rellena de helio, lo que reduce la fricción y permite introducir más platos en el mismo volumen.

En los anales de la historia, los discos duros tenían uno o dos platos. Pero conforme ha aumentado la necesidad de capacidad, los fabricantes han conseguido integrar hasta 10 u 11 platos en la misma carcasa de 3,5 pulgadas. Una evolución que ha sido posible gracias a dos avances fundamentales: el uso de helio (que permite colocar los platos más juntos sin sobrecalentamiento ni turbulencias) y la optimización de las técnicas de grabación magnética.

Entonces, ¿HDD o SSD?

La pregunta del millón es si los discos duros tienen sentido ante la irrupción en escena de los discos de estado sólido (SSD) que integran la mayor parte de los dispositivos de consumo en la actualidad y que, también, se van haciendo un hueco en los centros de datos. Los fabricantes de estos últimos no dudan en anticipar el fin de los discos duros («Los discos magnéticos de almacenamiento de datos son los nuevos dinosaurios», defiende por ejemplo Charles Giancarlo, CEO mundial de Pure Storage)

La respuesta, desde el polo de los proveedores de soluciones magnéticas, es obvia: ambas tecnologías seguirán coexistiendo, pero sus diferencias determinan claramente para qué sirven mejor.

Empecemos por lo más evidente: su diseño interno. Los HDD, como hemos anticipado, dependen de platos giratorios y cabezales mecánicos que escriben y leen mediante campos magnéticos. Esta mecánica precisa implica ciertas limitaciones físicas, como una velocidad de acceso a los datos mucho menor o un mayor riesgo de fallo por golpes o desgaste mecánico.

Los SSD, por el contrario, no tienen partes móviles. Utilizan chips de memoria flash para almacenar la información, lo que permite leer y escribir datos prácticamente al instante. En otras palabras, tiempos de arranque de sistema mucho más rápidos, aplicaciones que se abren en segundos y un rendimiento más fluido incluso en tareas exigentes.

La diferencia de velocidad es abismal. Un HDD moderno alcanza entre 100 y 200 MB/s en lectura secuencial, mientras que un SSD SATA supera fácilmente los 500 MB/s. Los modelos más avanzados, conectados por interfaz NVMe, pueden superar los 7.000 MB/s.

Sin embargo, el coste sigue siendo el gran factor diferenciador. Los HDD ofrecen una relación precio-capacidad imbatible, en la mentada relación de 1 a 7. Esto explica por qué los grandes centros de datos, servicios de backup, videovigilancia o almacenamiento en frío siguen apostando por HDD: no necesitan velocidad, sino capacidad y precio bajo por gigabyte.

También encontramos diferencias en cuanto a la eficiencia energética. Al carecer de motores y fricción, los SSD consumen menos energía y generan menos calor. También son silenciosos y más resistentes a los golpes o vibraciones, lo que los hace ideales para dispositivos móviles.

Pero los SSD no están exentos de limitaciones. Aunque su resistencia física es superior, sus celdas de memoria tienen un número limitado de ciclos de escritura. A largo plazo, pueden degradarse si se usan de forma intensiva, especialmente en modelos de gama baja sin controladores avanzados o sistemas de nivelación de desgaste. Además, si se almacenan apagados durante años, los datos pueden deteriorarse, algo que no ocurre tan fácilmente con los HDD.

Mucha vida por delante

Así que parece obvio que, en lugar de desaparecer, el disco duro tradicional está encontrando su nuevo lugar en el ecosistema digital, gracias a la innovación tecnológica y a la demanda creciente de capacidad por parte de sectores como el vídeo, la inteligencia artificial o los servicios en la nube.

“Los HDD y los SSD no compiten entre sí en centros de datos; cumplen funciones distintas”, insiste Rainer W. Kaese, Senior Manager Storage Products Division de Toshiba Electronics Europe. La velocidad de los SSD es inigualable, pero cuando lo que se necesita es almacenar enormes volúmenes de información de forma fiable y rentable, el HDD sigue siendo imbatible.

Esa confianza no es gratuita. Toshiba está invirtiendo fuerte en nuevas tecnologías como MAMR y HAMR, que permiten incrementar la densidad de datos sin comprometer la integridad ni la eficiencia térmica. La primera (grabación asistida por microondas) ya ha permitido lanzar discos de 24 TB, y se prepara una nueva generación de 28 TB. La segunda (grabación asistida por calor, mediante láser) tiene un potencial aún mayor —hasta 40 o 50 TB—, aunque su despliegue requiere superar desafíos de coste y fiabilidad.

“Sabemos que funciona físicamente y que es fiable; lo que no está claro aún es si se podrá fabricar a gran escala por un precio asumible”, explica Kaese. Sin una reducción clara de costes, no se lanzará al mercado: el HDD solo tiene sentido si sigue ofreciendo más capacidad por menos dinero.

Rainer W. Kaese, director senior de Desarrollo de negocio de HDD de Toshiba Electronics Europe.

En paralelo, Toshiba está rediseñando por completo los factores de forma, la eficiencia térmica y la arquitectura interna de los HDD. En su haber ya está el uso de helio para reducir fricción y permitir más platos, hasta la optimización de cajas, ventilación y controladores en entornos reales. En su laboratorio europeo reproducen escenarios complejos con cientos de discos funcionando en paralelo, simulando cargas de streaming para decenas de miles de usuarios y midiendo en tiempo real el consumo, la temperatura y la latencia. Han demostrado que, con la configuración adecuada, pueden alcanzar velocidades de lectura y escritura de más de 9 GB/s solo con HDD, sin necesidad de cachés SSD.

“Lo importante es conocer el sistema completo y optimizarlo; el disco duro no es el cuello de botella si se hace bien”, asegura el directivo.

Además, Toshiba reivindica el valor ecológico del HDD frente a los SSD, desafiando la percepción extendida de que los discos duros son menos sostenibles. “En igualdad de condiciones, un SSD de alta gama puede consumir más energía que un HDD bajo carga máxima”, afirma Kaese. Y al final de su vida útil, el HDD tiene una ventaja clara: está hecho principalmente de aluminio y cobre, lo que facilita su reciclaje frente a los componentes sellados y difíciles de desmontar de los SSD.

A eso se suma una mayor transparencia en los ciclos de vida: los centros de datos ya no reemplazan discos defectuosos salvo que afecten al rendimiento general. Se asume su tasa de fallo como parte del sistema.

Con todo ello, Toshiba aspira a pasar del 19% al 25% del mercado global de HDD en los próximos tres años, centrándose especialmente en los grandes centros de datos (hiperescalares) y en sectores como la videovigilancia.

“El HDD no va a desaparecer mientras la industria necesite almacenar más datos a bajo coste. Si alguna vez no podemos seguir ofreciendo más capacidad por el mismo precio, ese será el final. Pero aún no estamos ni cerca de ese punto”, sentencia Rainer W. Kaese a DISRUPTORES – EL ESPAÑOL.

Del vidrio de cuarzo al ADN

A pesar de todas las innovaciones, es imposible obviar que el disco duro se está acercando a sus límites físicos. La arquitectura de los HDD depende de una delicada combinación de densidad, precisión mecánica y estabilidad térmica. Hasta ahora, tecnologías como la grabación asistida por microondas (MAMR) y por calor (HAMR) han permitido seguir exprimiendo esa fórmula. Pero más allá de los 40 o 50 terabytes por unidad, las barreras se vuelven mucho más difíciles de sortear.

Uno de los principales cuellos de botella es el tamaño del cabezal de escritura. Para aumentar la densidad de datos habría que reducir su tamaño, pero sin sacrificar la energía magnética necesaria para alterar los bits. Si se disminuye demasiado, no se genera suficiente campo magnético para escribir. De ahí el uso de energía externa —microondas o láser— que “asista” el proceso. Aun así, más allá de cierto umbral, los problemas de fiabilidad, desgaste y disipación térmica hacen que los costes se disparen. “Podemos fabricar un disco de 40 TB, incluso de 50, pero no tiene sentido si cuesta tres veces más que dos de 24 TB”, explican desde Toshiba.

Por eso la industria ya explora caminos más radicales. Uno de los más prometedores es el almacenamiento en vidrio de cuarzo. Este sistema graba datos en varias capas tridimensionales dentro de un bloque de vidrio mediante láseres ultrarrápidos. Es extremadamente duradero —puede resistir fuego, agua y campos magnéticos— y se perfila como una solución ideal para archivos permanentes, con una longevidad potencial de miles de años. Sin embargo, su velocidad de escritura aún es lenta y su uso está limitado, de momento, al mundo académico.

Otra línea de investigación más ambiciosa, aunque aún en fase experimental, es el almacenamiento en ADN. Aprovechando la capacidad natural del ácido desoxirribonucleico para codificar información en cuatro bases químicas (A, T, C y G), científicos han logrado almacenar libros, vídeos e incluso sistemas operativos enteros en cadenas sintéticas de ADN. En teoría, un solo gramo de ADN podría contener hasta 215 petabytes de datos, una densidad que supera en órdenes de magnitud a cualquier tecnología actual. El problema, por ahora, es su altísimo coste y la lentitud del proceso de lectura y escritura. Pero como ocurrió con los discos duros hace medio siglo, podría ser solo cuestión de tiempo.

Puedes consultar la fuente de este artículo aquí